皆さま、こんにちは!

最近、ChatGPTを使いはじめたものの、「この情報、本当に正しいのかな?」と心配になることはありませんか?

その疑問、、、正しいです!!

ChatGPTを含む各種生成AIには、事実と異なる情報を堂々と回答する「ハルシネーション」という現象があります。生成AIユーザーにとっては、まさに罠!深刻な問題なんです。

でも、安心してください。

今回は、ChatGPTのハルシネーション対策テクニック6選を、初心者の方でも今すぐ実践できるよう解説していきたいと思います。

ChatGPTのハルシネーションとは?原因と事例

まず、「ハルシネーション」について理解していきましょう。

ハルシネーションの定義

生成AIのハルシネーションとは、AIが実際には存在しない情報や、事実と異なる内容を「自信満々」に生成してしまう現象のことです。

ハルシネーションという言葉は、幻覚や錯覚を意味し、文字通りAIがまるで幻覚を見たかのように誤った情報を語り始めるところからきていると言われています。

皆さまご存知のとおり、従来のシステムなら「該当する情報が見つかりません」と正直に答えるところを、ChatGPTなどの生成AIは「それらしい答え」を作り出してしまうんですね。

なぜハルシネーションが起こるのか?

これには、ChatGPTの仕組みそのものが関係しています。

ChatGPTなどの大規模言語モデル(LLM)は、「確率的にもっともらしいテキストを生成する」という仕組みで動作しているわけです。

OpenAI自身が2024年の研究で明らかにしたところによると、この問題は「現在の開発エコシステムが生み出す必然的な結果」なんです[1]。

つまり、単なるバグではなく、AIが情報の正誤や新旧を自律的に判断できないことが根本原因なんですね。

この生成AIの仕組みに関しては、こちらの記事でご紹介しているので詳しく知りたい方はぜひご覧ください。

代表的なハルシネーション事例

2025年最新の事例を見てみましょう。

実際に、ユタ州の弁護士がChatGPTで作成した「Royer v Nelson」という存在しない判例を法廷に提出してしまい、制裁処分を受けるという事件が起きています。

また、ノルウェーの男性が「息子2人を殺害し21年間収監された」という完全に虚偽の情報を生成され、データ保護当局に苦情を申し立てた例もあります[2]。

さらに恐ろしいのは、最新のGPT-5でも「ハルシネーション率が低減された」とは言われているものの、完全になくなったわけではないということなんです。

ChatGPT ハルシネーション対策のテクニック6選

ここまで説明ばかりで、少し退屈だったと思いますので、いよいよ本題の対策テクニックに入っていきましょう!

1. プロンプトに「わからないことは素直にわからないと答えること」と加える

最初のテクニックは、プロンプト設計の工夫です。

ChatGPTに質問する際、必ず以下のような指示を加えるようにしてください:

わからないことは「わからない」と素直に答えてください。これだけでも、ChatGPTが「知ったかぶり」をする確率を大幅に下げることができるわけです。

OpenAIでも、「モデルに『わからない』と言うことを明示的に許可することで、最小限のオーバーヘッドでハルシネーションを効果的に抑制できる」ことが語られています[4]。

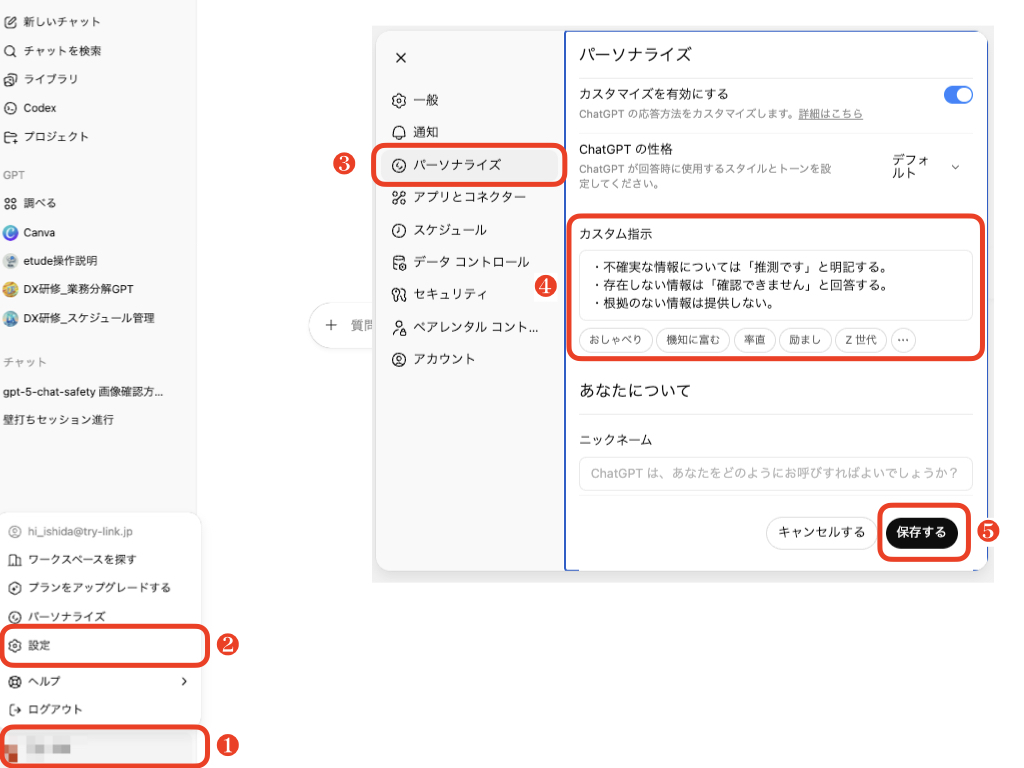

2. カスタム指示に「わからないことは素直にわからないと答えること」と加える

ChatGPTのカスタム指示を活用する方法ですね。

カスタム指示とは、お使いのChatGPTにすべてのスレッドで守らせたいプロンプト(指示文)を埋め込んでおく機能です。

ChatGPTの設定画面で、以下のような内容をカスタム指示に追加しておきましょう:

- 不確実な情報については「推測です」と明記する

- 存在しない情報は「確認できません」と回答する

- 根拠のない情報は提供しない

この設定により、すべての会話で一貫した対策を適用できるようになります。

設定方法は以下になります。

- ChatGPTの画面の左下にあるアカウントアイコンをクリック

- メニューから「設定」をクリック

- 「パーソナライズ」をクリック

- 「カスタム指示」の欄に上記の指示を加える

- 「保存」をクリック

3. 回答時に根拠や出典を必ず明記させる

3つ目のテクニックは、情報の透明性を高める方法です。

質問の際に、以下のように指示してみてください:

この回答について、可能な限り具体的な根拠や出典を示してください。

根拠が不明な場合は「根拠不明」と明記してください。ただし、現在のChatGPTは実際にウェブ検索を行わない限り、最新の出典を正確に提示することは困難な点には留意が必要です。

4. 回答の信頼度・確信度を答えさせる

4つ目は、AIに自分の回答への確信度を評価させる方法です。

以下のような指示を追加してください:

この回答の信頼度を1-10のスケールで評価してください。

また、なぜその評価になるのかも説明してください。ChatGPTが「信頼度3/10:推測に基づく情報です」と回答した場合、その情報には特に注意が必要だということがわかりますね。

この手法は、AI透明性と不確実性定量化の研究でもサポートされています。

5. 他社モデルを使ったクロスチェック(ClaudeやGeminiなどにも聞く)

5つ目は、複数のAIモデルで同じ質問をする「クロスチェック」です。

同じ質問をClaudeやGeminiなどのモデルにも投げかけて、回答が一致するかどうかを確認しましょう。

「すべてのAIモデルが同じタイプの誤りを犯す可能性がある」という点にも注意が必要ですが、明らかに矛盾する回答が出た場合は要注意です。研究でも、複数AIモデルでのクロスチェックは実践的に有効とされています。

6. 自分で再検索

最後のテクニックは、最終的には自分でチェックしましょう、という身も蓋もないお話です。

会議で扱うデータ、人に伝える大事な情報などは、やはり自分でチェックするのが一番です。

ただ、ここまでの検索過程でAIが論拠とする記事や情報はわかっているかと思います。

そう考えると1から調べなければいけなかった以前までと比べると明らかに効率は良くなっているはずです。

「ググれ」という言葉がありますが、AI検索時代においてもこの基本は必須なんですね。

初心者が知っておきたいAI活用の注意点

皆さま、ここまでの対策テクニックはいかがでしたでしょうか?

続いて、生成AI初心者の皆さまが安全にAIを活用するための、より広い視点での注意点をお話していきたいと思います。

誤情報の見抜き方

では、どのような場合に「これは怪しいな」と判断すべきでしょうか?

以下のポイントを意識してみてください:

- 具体的な数値が含まれているが、出典が明記されていない情報

- 最近の出来事に関する詳細すぎる情報

- 専門的すぎる内容なのに簡潔すぎる説明

- 一般常識と明らかに矛盾する内容

特に、統計データや歴史的事実、固有名詞などは、ハルシネーションが起こりやすい分野だと覚えておいてください。

AIの限界と人間の役割

ここで重要なのは、AIは「完璧な存在ではない」ということを理解することですね。

OpenAIの研究によると、最新モデルでもハルシネーションを完全に排除することは困難な状況です[1]。

つまり、私たち人間には以下のような役割が求められているわけです:

- AIの出力を批判的に吟味する「AIリテラシー」

- 最終的な判断は人間が行う責任感

- 専門分野では必ず専門家による確認を経る体制

よくある質問(FAQ)

Q1. 生成AIのハルシネーションとは何ですか?

ハルシネーションとは、AIが事実と異なる内容を自信満々に生成してしまう現象のことです。

単なる技術的な不具合ではなく、確率的にテキストを生成するAIの仕組み上、避けられない現象だと言えますね。

Q2. なぜAIは誤った情報を出すのですか?

これには2つの主要な原因があります。

まず、AIは「真偽を判断する」のではなく「統計的にもっともらしいテキストを生成する」仕組みで動作していることです。

また、学習データには不正確な情報や古い情報も含まれており、AIはこれらの正誤を自律的に判断できないわけです。

Q3. ハルシネーションを完全に防ぐ方法はありますか?

残念ながら、現在の技術では完全に防ぐことはできません。

ただし、今回ご紹介した6つのテクニックを組み合わせることで、発生率を大幅に下げることは可能です。

大切なのは「完璧を求めず、実用的なレベルを目指す」という考え方ですね。

Q4. 初心者でもできる簡単な対策は?

最も簡単で効果的な対策は、プロンプトに「わからないことは素直にわからないと答えてください」という指示を加えることです。

これだけでも、AIの「知ったかぶり」を大幅に減らすことができますよ。

また、重要な情報については必ず「自分でググって確認する」習慣をつけることも重要ですね。

Q5. 他のAIモデルも同じ問題がありますか?

はい、Claude、Gemini、Copilotなど、すべての大規模言語モデルで同様の問題が発生します。

これは大規模言語モデルの根本的な仕組みに起因する現象のため、どのAIサービスでも完全に避けることはできない問題なんです。

だからこそ、どのAIを使う場合でも、今回ご紹介した対策テクニックが重要になってくるわけです。

皆さま、いかがでしたでしょうか?

今回は「【知らなきゃ損】ChatGPT ハルシネーション対策 6選|初心者でもできる具体的な方法を解説」について、初心者の皆さまでも今すぐ実践できる具体的な方法を解説させていただきました。

重要なのは、AIを「完璧な存在」と過信せず、適切な距離感を保ちながら活用することですね。

ハルシネーション対策は一度設定すれば終わりではなく、AI技術の進歩に合わせて継続的にアップデートしていく必要があります。

でも、今回ご紹介した6つのテクニックを実践していけば、皆さまのAI活用は格段に安全で効率的になると思います。

ぜひ、明日からの業務で試してみてくださいね!

最終更新日:2025年10月21日

※免責事項

本記事の情報は執筆時点のものです。AI技術は急速に進歩しているため、最新情報については各サービスの公式サイトをご確認ください。

Citations:

[1] https://openai.com/safety/evaluations-hub/

[2] https://www.bbc.com/japanese/articles/c4ge4xjrxl0o

[3] https://news.microsoft.com/ja-jp/2024/12/18/241218-operational-efficiency-and-innovation-enabled-by-ai-agents-latest-case-studies-from-japan/

[4] https://openai.com/index/why-language-models-hallucinate/